万字研报 | AI与Web3数据行业融合现状、竞争格局与未来机遇探析

GPT的横空出世将全球的目光吸引至大语言模型,各行各业都尝试着利用这个“黑科技”提高工作效率,加速行业发展。Future3 Campus携手Footprint Analytics共同深入研究AI与Web3结合的无限可能,联合发布了《AI与Web3数据行业融合现状、竞争格局与未来机遇探析》研报。

摘要:

LLM 技术的发展让人们更加关注 AI 与 Web3 的结合,新的应用范式正在逐步展开。本文中,我们将重点研究如何利用 AI 提升 Web3 数据的使用体验和生产效率。

由于行业尚处早期阶段和区块链技术的特性,Web3 数据行业面临着诸多挑战,包括数据来源、更新频率、匿名属性等,使得利用 AI 解决这些问题成为新关注点。

LLM 相对于传统人工智能的可扩展性、适应性、效率提升、任务分解、可访问性和易用性等优势,为提高区块链数据的体验和生产效率提供了想象空间。

LLM 需要大量高质量数据进行训练,而区块链领域垂直知识丰富且数据公开,可以为 LLM 提供学习素材。

LLM 也可以帮助生产和提升区块链数据的价值,例如数据清洗、标注、生成结构化数据等。

LLM 不是万灵药,需要针对具体业务需求进行应用。既要利用 LLM 的高效率,同时也要注意结果的准确性。

All walks of life are trying to use this black technology to improve work efficiency, accelerate the development of the industry, and jointly publish the infinite possibility of in-depth research and integration with the data industry. The summary of the research report on the current situation, competition pattern and future opportunities of integration with the data industry has attracted people's attention and integration. The new application paradigm is gradually unfolding. In this paper, we will focus on how to use it to improve the use experience and production efficiency of data due to the industry. It is still in the early stage and the characteristics of blockchain technology. The data industry is facing many challenges, including the frequency of data source update, anonymity and so on, which makes the use of solving these problems a new concern. Compared with traditional artificial intelligence, it has the advantages of scalability, adaptability, efficiency, accessibility and ease of use of task decomposition, which provides imagination space for improving the experience and production efficiency of blockchain data. It needs a lot of high-quality data for training, while the vertical knowledge in blockchain field is rich and data disclosure can provide. Learning materials can also help to produce and enhance the value of blockchain data, such as data cleaning, labeling, generating structured data, etc. It is not a panacea that needs to be applied for specific business needs, not only to use high efficiency, but also to pay attention to the accuracy of results. 比特币今日价格行情网_okx交易所app_永续合约_比特币怎么买卖交易_虚拟币交易所平台

AI 与 Web3 的数据结合正在促进数据处理效率的提升和用户体验的改善。目前区块链数据行业对于 LLM 的探索主要集中在通过 AI 技术来提高数据处理效率,利用 LLM 交互优势构建 AI Agent,以及利用 AI 进行定价和交易策略分析等。

目前 AI 在 Web3 数据领域的应用还面临一些挑战,如准确性、可解释性、商业化等。完全取代人工介入还有很长的路要走。

Web3 数据公司的核心竞争力不仅仅是 AI 技术本身,还在于数据积累能力和对数据的深入分析应用能力。

AI 可能短期内不是解决数据产品商业化问题的解决方案,商业化需要更多的产品化努力。

1.AI 与 Web3 的发展与结合

1.1 AI 的发展历史

人工智能(AI)的历史可以追溯到上个世纪 50 年代。自 1956 年起,人们开始关注人工智能这一领域,逐渐发展出了早期的专家系统,帮助专业领域解决问题。此后,机器学习的兴起,拓展了 AI 的应用领域,AI 开始更广泛地应用在各行各业。到如今,深度学习和生成式人工智能爆发,带给了人们无限可能性,其中的每一步都充满了不断的挑战与创新,以追求更高的智能水平和更广泛的应用领域。

图 1:AI 发展历程

2022 年 11 月 30 日,ChatGPT 面世,首次展示了 AI 与人类低门槛、高效率交互的可能性。ChatGPT 引发了对人工智能的更广泛探讨,重新定义了与 AI 互动的方式,使其变得更加高效、直观和人性化,也推动了人们对更多生成式人工智能的关注,Anthropic(Amazon)、DeepMind(Google)、Llama 等模型也随后进入人们的视野。与此同时,各行各业的从业者也开始积极探索 AI 会如何推动他们所在领域的发展,或者寻求通过与 AI 技术的结合在行业中脱颖而出,进一步加速了 AI 在各个领域的渗透。

1.2 AI 与 Web3 的交融

Web3 的愿景从改革金融体系开始,旨在实现更多的用户权力,并有望引领现代经济和文化的转变。区块链技术为实现这一目标提供了坚实的技术基础,它不仅重新设计了价值传输和激励机制,还为资源分配和权力分散提供了支持。

图 2:Web3 发展历程

早在 2020 年,区块链领域的投资公司 Fourth Revolution Capital(4RC)就曾指出,区块链技术将和 AI 结合,通过对金融、医疗、电子商务、娱乐等全球行业的去中心化,以实现对现有行业的颠覆。

目前,AI 与 Web3 的结合,主要是两大方向:

利用 AI 去提升生产力以及用户体验。

结合区块链透明、安全、去中心化存储、可追溯、可验证的技术特点,以及 Web3 去中心化的生产关系,解决传统技术无法解决的痛点或者激励社区参与,提高生产效率。

市场上 AI 与 Web3 的结合有以下的一些探索方向:

图 3:AI 与 Web3 结合全景图

数据:区块链技术可以应用在模型数据存储上,提供加密数据集,保护数据隐私和记录模型使用数据的来源、使用情况,以及校验数据的真实性。通过访问和分析存储在区块链上的数据,AI 可以提取有价值的信息,并用于模型训练和优化。同时,AI 也可以作为数据生产工具,去提高 Web3 数据的生产效率。

算法:Web3 中的算法可以为 AI 提供更安全、可信和自主控制的计算环境,为 AI 体统提供加密保障,在模型参数上,内嵌安全防护栏,防止系统被滥用或者恶意操作。AI 可以与 Web3 中的算法进行交互,例如利用智能合约执行任务、验证数据和执行决策。同时,AI 的算法也可以为 Web3 提供更智能化和高效的决策和服务。

算力:Web3 的分散式计算资源可以为 AI 提供高性能的计算能力。AI 可以利用 Web3 中的分散式计算资源进行模型的训练、数据分析和预测。通过将计算任务分发到网络上的多个节点,AI 可以加快计算速度,并处理更大规模的数据。

在本文中,我们将重点探索如何利用 AI 的技术,去提升 Web3 数据的生产效率以及使用体验。

2.Web3数据现状

2.1 Web2 & Web3 数据行业对比

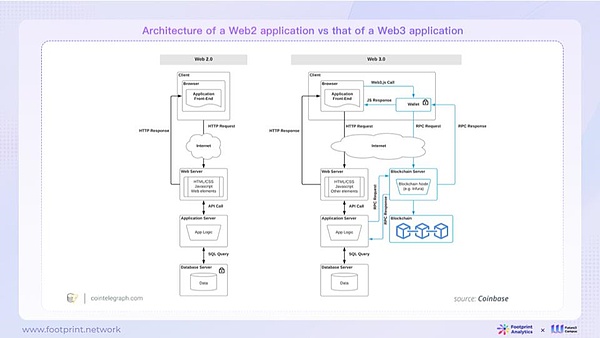

作为 AI 最核心的组成部分“数据”,在 Web3 跟我们熟悉的 Web2 很着很多的区别。差异主要是在于 Web2 以及 Web3 本身的应用架构导致其产生的数据特征有所不同。

2.1.1 Web2 & Web3 应用架构对比

图 4:Web2 & Web3 应用架构

在 Web2 架构中,通常是由单一实体(通常是一家公司)来控制网页或者 APP,公司对于他们构建的内容有着绝对的控制权,他们可以决定谁可以访问其服务器上的内容和逻辑,以及用户拥有怎样的权益,还可以决定这些内容在网上存在的时长。不少案例表明,互联网公司有权改变其平台上的规则,甚至中止为用户提供服务,而用户对此无法保留所创造的价值。

而 Web3 架构则借助了通用状态层(Universal State Layer)的概念,将一部分或者全部的内容和逻辑放置在公共区块链上。这些内容和逻辑是公开记录在区块链上的,可供所有人访问,用户可以直接控制链上内容和逻辑。而在 Web2 中,用户需要帐户或 API 密钥才能与区块链上的内容进行交互。用户可以直接控制其对应的链上内容和逻辑。不同于 Web2,Web3 用户无需授权帐户或 API 密钥就能与区块链上的内容进行交互(特定管理操作除外)。

2.1.2 Web2 与 Web3 数据特征对比

图 5:Web2 与 Web3 数据特征对比

Web2 数据通常表现为封闭和高度受限的,具有复杂的权限控制,高度成熟、多种数据格式、严格遵循行业标准,以及复杂的业务逻辑抽象。这些数据规模庞大,但互操作性相对较低,通常存储在中央服务器上,且不注重隐私保护,大多数是非匿名的。

相比之下,Web3 数据更加开放,访问权限更广泛,尽管成熟度较低,以非结构化数据为主,标准化较为罕见,业务逻辑抽象相对简化。Web3 的数据规模相对 Web2 较小,但它具有较高的互操作性(比如 EVM 兼容),并可分散或集中存储数据,同时强调用户隐私,用户通常采用匿名方式进行链上交互。

2.2 Web3 数据行业现状与前景,以及遇到的挑战

在 Web2 时代,数据如石油的“储量”般珍贵,访问和获取大规模数据一直是极大的挑战。在 Web3 中,数据的开放性和共享性一下子让大家觉得“石油到处都是”,使得 AI 模型能够更轻松地获取更多的训练数据,这对于提高模型性能和智能水平至关重要。但对 Web3 这个“新石油” 的数据处理依然有很多问题待解决,主要有以下几个:

数据来源:链上数据“标准”繁杂分散,数据处理花费大量人工成本

处理链上数据时,需要反复执行耗时而劳动密集的索引过程,需要开发者和数据分析师花费大量时间和资源来适应不同链、不同项目之间的数据差异。链上数据行业缺乏统一的生产和处理标准,除了记录到区块链账本上的,events,logs,and traces 等都基本上是项目自己定义和生产(或生成)的,这导致非专业交易者很难辨别并找到最准确和可信的数据,增加了他们在链上交易和投资决策中的困难。比如,去中心化交易所 Uniswap 和 Pancakeswap 就有可能在数据处理方法和数据口径上存在差异,过程中的检查和统一口径等工序进一步加大了数据处理的复杂性。

数据更新:链上数据体量大且更新频率高,难以及时地处理成结构化数据

区块链是时刻变动的,数据更新以秒甚至毫秒级别计。数据的频繁产生和更新使其难以维持高质量的数据处理和及时的更新。因此,自动化的处理流程是十分重要的,这也是对于数据处理的成本和效率的一大挑战。Web3 数据行业仍处于初级阶段。随着新合约的层出不穷和迭代更新,数据缺乏标准、格式多样,进一步增加了数据处理的复杂性。

数据分析:链上数据的匿名属性,导致数据身份难以区分

链上数据通常不包含足够的信息来清晰识别每个地址的身份,这使得数据在与链下的经济、社会或法律动向难以联动。但是链上数据的动向与现实世界紧密相关,了解链上活动与现实世界中特定个体或实体的关联性对于特定的场景比如数据分析来说十分重要。

随着大语言模型(LLM)技术引发的生产力变更讨论,能否利用 AI 来解决这些挑战也成为 Web3 领域的一个焦点关注之一。

3.AI 与 Web3 数据碰撞产生的化学反应

3.1 传统 AI 与 LLM 的特征对比

在模型训练方面,传统 AI 模型通常规模较小,参数数量在数万到数百万之间,但为了确保输出结果的准确性,需要大量的人工标注数据。LLM 之所以如此强大,部分原因在于其使用了海量的语料拟合百亿、千亿级以上的参数,极大地提升了它对自然语言的理解能力,但这也意味着需要更多的数据来进行训练,训练成本相当高昂。

在能力范围和运行方式上,传统 AI 更适合特定领域的任务,能够提供相对精准和专业的答案。相比之下,LLM 更适合通用性任务,但容易产生幻觉问题,这意味着在一些情况下,它的回答可能不够精确或专业,甚至完全错误。因此,如果需要和客观,可信任,和可以追溯的结果,可能需要进行多次检查、多次训练或引入额外的纠错机制和框架。

图 6:传统 AI 与大模型语言模型 (LLM)的特征对比

3.1.1 传统 AI 在 Web3 数据领域的实践

传统 AI 已经在区块链数据行业展现了其重要性,为这一领域带来了更多创新和效率。例如,0xScope 团队采用 AI 技术,构建了基于图计算的群集分析算法,通过不同规则的权重分配来帮助准确识别用户之间的相关地址。这种深度学习算法的应用提高了地址群集的准确性,为数据分析提供了更精确的工具。Nansen 则将 AI 用于 NFT 价格预测,通过数据分析和自然语言处理技术,提供有关 NFT 市场趋势的见解。另一方面,Trusta Labs使用了基于资产图谱挖掘和用户行为序列分析的机器学习方法,以增强其女巫检测解决方案的可靠性和稳定性,有助于维护区块链网络生态的安全。另一方面,Trusta Labs 采用了图挖掘和用户行为分析的方法,以增强其女巫检测解决方案的可靠性和稳定性,有助于维护区块链网络的安全。Goplus 在其运营中利用传统人工智能来提高去中心化应用程序(dApps)的安全性和效率。他们收集和分析来自 dApp 的安全信息,提供快速风险警报,帮助降低这些平台的风险敞口。这包括通过评估开源状态和潜在恶意行为等因素来检测 dApp 主合同中的风险,以及收集详细的审计信息,包括审计公司凭证、审计时间和审计报告链接。Footprint Analytics 则使用 AI 生成生产结构化数据的代码,分析 NFT 交易 Wash trading 交易以及机器人账户筛选排查。

然而,传统 AI 拥有的信息有限,专注于使用预定的算法和规则执行预设任务,而 LLM 则通过大规模的自然语言数据学习,可以理解和生成自然语言,这使其更适合处理复杂且巨量的文本数据。

最近,随着 LLM 取得了显著进展,人们对 AI 与 Web3 数据的结合,也进行了一些新的思考与探索。

3.1.2 LLM 的优势

LLM 相对于传统人工智能具有以下优势:

可扩展性:LLM 支持大规模数据处理

LLM 在可扩展性方面表现出色,能够高效处理大量数据和用户互动。这使其非常适合处理需要大规模信息处理的任务,如文本分析或者大规模数据清洗。其高度的数据处理能力为区块链数据行业提供了强大的分析和应用潜力。

适应性:LLM 可学习适应多领域需求

LLM 具备卓越的适应性,可以为特定任务进行微调或嵌入行业或私有数据库,使其能够迅速学习和适应不同领域的细微差别。这一特性使 LLM 成为了解决多领域、多用途问题的理想选择,为区块链应用的多样性提供了更广泛的支持。

提高效率:LLM 自动化任务提高效率

LLM 的高效率为区块链数据行业带来了显著的便利。它能够自动化原本需要大量人工时间和资源的任务,从而提高生产力并降低成本。LLM 可以在几秒内生成大量文本、分析海量数据集,或执行多种重复性任务,从而减少了等待和处理时间,使区块链数据处理更加高效。

任务分解:可以生成某些工作的具体计划,把大的工作分成小步骤

LLM Agent 具备独特的能力,即可以生成某些工作的具体计划,将复杂任务分解为可管理的小步骤。这一特性对于处理大规模的区块链数据和执行复杂的数据分析任务非常有益。通过将大型工作分解成小任务,LLM 可以更好地管理数据处理流程,并输出高质量的分析。

这一能力对于执行复杂任务的 AI 系统至关重要,例如机器人自动化、项目管理和自然语言理解与生成,使其能够将高级任务目标转化为详细的行动路线,提高任务执行的效率和准确性。

可访问性和易用性:LLM 以自然语言提供用户友好互动

LLM 的可访问性使更多用户能够轻松与数据和系统进行互动,让这些互动更加用户友好。通过自然语言,LLM 使数据和系统更容易访问和交互,无需用户学习复杂的技术术语或特定命令,例如,SQL,R,Python 等来做数据获取和分析。这一特性拓宽了区块链应用的受众范围,让更多的人能够访问和使用 Web3 应用和服务,不论他们是否精通技术,从而促进了区块链数据行业的发展和普及。

3.2 LLM 与 Web3 数据的融合

图 7:区块链数据与 LLM 的融合

大型语言模型的培训需要依赖大规模数据,通过学习数据中的模式来建立模型。区块链数据中蕴含的交互和行为模式是 LLM 学习的燃料。数据量和质量也直接影响 LLM 模型的学习效果。

数据不仅仅是 LLM 的消耗品,LLM 还有助于生产数据,甚至可以提供反馈。例如,LLM 可以协助数据分析师在数据预处理方面做出贡献,如数据清洗和标注,或者生成结构化数据,清除数据中的噪声,凸显有效信息。

3.3 增强 LLM 的常用技术解决方案

ChatGPT 的出现,不仅向我们展示了 LLM 解决复杂问题的通用能力,同时也引发了全球范围的,对在通用能力上去叠加外部能力的探索。这里包括,通用能力的增强(包括上下文长度、复杂推理、数学、代码、多模态等)以及外部能力的扩充(处理非结构化数据、使用更复杂的工具、与物理世界的交互等)。如何将 crypto 领域的专有知识以及个人的个性化私有数据嫁接到大模型的通用能力上,是大模型在 crypto 垂直领域商业化落地的核心技术问题。

目前,大多数应用都集中在检索增强生成(RAG)上,比如提示工程和嵌入技术,已经存在的代理工具也大多都聚焦于提高 RAG 工作的效率和准确性。市场上主要的基于 LLM 技术的应用栈的参考架构有以下几种:

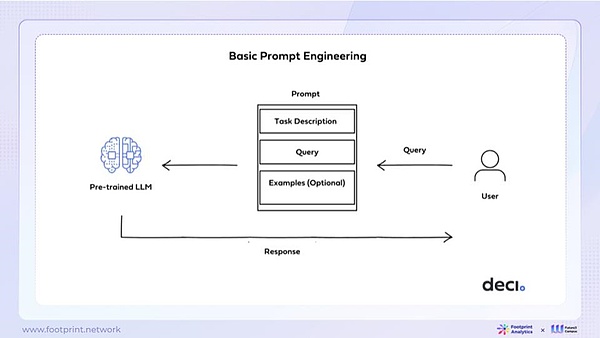

Prompt Engineering

图 8:Prompt Engineering

当前,大多数从业者在构建应用时采用基础解决方案,即 Prompt Engineering。这一方法通过设计特定的 Prompt 来改变模型的输入,以满足特定应用的需求,是最方便快捷的做法。然而,基础的 Prompt Engineering 存在一些限制,如数据库更新不及时、内容冗杂、以及对输入上下文长度(In-Context Length)的支持和多轮问答的限制。

因此,行业内也在研究更先进的改进方案,包括嵌入(Embedding)和微调(Fine-tuning)。

嵌入(Embedding)

嵌入(Embedding)是一种广泛应用于人工智能领域的数据表示方法,能高效捕获对象的语义信息。通过将对象属性映射成向量形式,嵌入技术能够通过分析向量之间的相互关系,快速找到最有可能正确的答案。嵌入可以在 LLM 的基础上构建,以利用该模型在广泛语料上学到的丰富语言知识。通过嵌入技术将特定任务或领域的信息引入到预训练的大模型中,使得模型更专业化,更适应特定任务,同时保留了基础模型的通用性。

用通俗的话来讲,嵌入就类似于你给一个经过综合训练的大学生一本工具书,让他拿着拥有特定任务相关知识的工具书去完成任务,他可以随时查阅工具书,然后可以解决特定的问题。

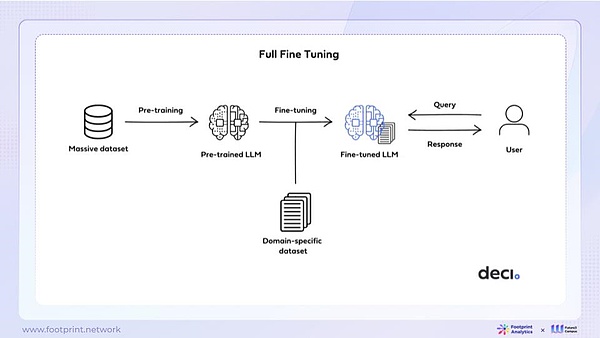

微调(Fine-tuning)

图 9:Fine Tuning

微调(Fine-tuning)与嵌入不同,通过更新已经预训练的语言模型的参数,使其适应特定任务。这种方法允许模型在特定任务上表现出更好的性能,同时保持通用性。微调的核心思想是调整模型参数,捕捉与目标任务相关的特定模式和关系。但微调的模型通用能力上限仍然受限于基座模型本身。

用通俗的话来讲,微调就类似于给经过综合训练的大学生上专业知识课程,让他掌握除了综合能力以外的专业课知识,能自行解决专业板块的问题。

重新训练 LLM

当前的 LLM 虽然强大,但不一定能够满足所有需求。重新训练 LLM 是一种高度定制化的解决方案,通过引入新数据集和调整模型权重,使其更适应特定任务、需求或领域。然而,这种方法需要大量计算资源和数据,并且管理和维护重新训练后的模型也是挑战之一。

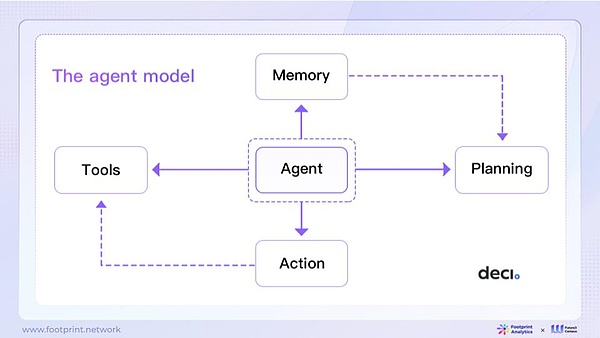

Agent 模型

图 10:Agent 模型

Agent 模型是一种构建智能代理的方法,它以 LLM 作为核心控制器。这个系统还包括几个关键组成部分,以提供更全面的智能。

Planning,规划:将大任务分成小任务,这样更容易完成

Memory,反思:通过反思过去的行为,改进未来的计划

Tools,工具使用:代理可以调用外部工具获取更多信息,如调用搜索引擎、计算器等

人工智能代理模型具备强大的语言理解和生成能力,能够解决通用问题,进行任务分解以及自我反思。这使得它在各种应用中都有广泛的潜力。然而,代理模型也存在一些局限性,例如受到上下文长度的限制、长期规划和任务拆分容易出错、输出内容的可靠性不稳定等问题。这些局限性需要长期不断的研究和创新,以进一步拓展代理模型在不同领域的应用。

以上的各种技术并不是相互排斥的,它们可以在训练和增强同一个模型的过程中一起使用。开发者可以充分发挥现有大语言模型的潜力,尝试不同的方法,以满足日益复杂的应用需求。这种综合使用不仅有助于提高模型的性能,还有助于推动 Web3 技术的快速创新和进步。

然而,我们认为,虽然现有的 LLM 已经在 Web3 的快速发展中发挥了重要作用,但在充分尝试这些现有模型(如 OpenAI、Llama 2 以及其他开源 LLM)之前,我们可以从浅入深,从 prompt engineering 和嵌入等 RAG 策略入手,谨慎考虑微调和重新训练基础模型。

3.4 LLM 如何加速区块链数据生产的各个流程

3.4.1 区块链数据的一般处理流程

当今,区块链领域的建设者逐渐认识到数据产品的价值。这一价值覆盖了产品运营监控、预测模型、推荐系统以及数据驱动的应用程序等多个领域。尽管这一认知逐渐增强,但作为数据获取到数据应用中不可或缺的关键步骤,数据处理往往被忽视。

图 12:区块链数据处理流程

将区块链原始非结构化数据,如 events 或 logs 等,转换为结构化的数据

区块链上的每一笔交易或事件都会生成 events 或 logs,这些数据通常是非结构化的。这一步骤是获取数据的第一入口,但数据仍然需要被进一步处理以提取有用信息,得到结构化的原始数据。这包括整理数据、处理异常情况和转化为通用格式。

将结构化的原始数据,转换为具有业务意义的抽象表

在得到结构化原始数据后,需要进一步进行业务抽象,将数据映射到业务实体和指标上,比如交易量、用户量等业务指标,将原始数据转化为对业务和决策有意义的数据。

从抽象表中,计算提取业务指标

有了抽象的业务数据后,可以在业务抽象的数据上进行进一步计算,就可以得出各种重要的衍生指标。例如交易总额的月增长率、用户留存率等核心指标。这些指标可以借助 SQL、Python 等工具实现,更加有可能帮助监控业务健康、了解用户行为和趋势,从而支持决策和战略规划。

3.4.2 区块链数据生成流程加入 LLM 后的优化

LLM 在区块链数据处理中可以解决多个问题,包括但不限于以下内容:

处理非结构化数据:

从交易日志和事件中提取结构化信息:LLM 可以分析区块链的交易日志和事件,提取其中的关键信息,如交易金额、交易方地址、时间戳等,将非结构化数据转化为的带有业务意义的数据,使其更易于分析和理解。

清洗数据,识别异常数据:LLM 可以自动识别和清洗不一致或异常的数据,帮助确保数据的准确性和一致性,从而提高数据质量。

进行业务抽象:

将原始链上数据映射到业务实体:LLM 可以将原始区块链数据映射到业务实体,例如将区块链地址映射到实际用户或资产,从而使业务处理更加直观和有效。

处理非结构化链上内容,打标签:LLM 可以分析非结构化数据,如 Twitter 情感分析结果,将其标记为正面、负面或中性情感,从而帮助用户更好地理解社交媒体上的情感倾向。

自然语言解读数据:

计算核心指标:基于业务抽象,LLM 可以计算核心业务指标,如用户交易量、资产价值、市场份额等,以帮助用户更好地了解其业务的关键性能。

查询数据:LLM 可以通过 AIGC,理解用户意图,生成 SQL 查询,使用户能够以自然语言提出查询请求,而不必编写复杂的 SQL 查询语句。这增加了数据库查询的可访问性。

指标选择、排序和相关性分析:LLM 可以帮助用户选择、排序和分析不同的多个指标,以更好地理解它们之间的关系和相关性,从而支持更深入的数据分析和决策制定。

产生业务抽象的自然语言描述:LLM 可以根据事实数据,生成自然语言摘要或解释,以帮助用户更好地理解业务抽象和数据指标,提高可解释性,并使决策更具合理性。

3.5 目前用例

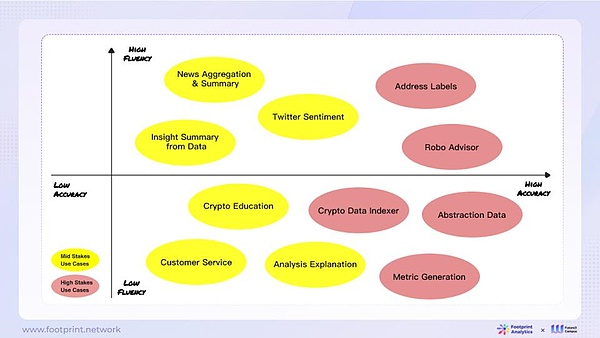

根据 LLM 自身的技术以及产品体验优势,它可以被应用到不同的链上数据场景,技术上从易到难可以将这些场景分成四类:

数据转换:进行数据增强、重构等操作,如文本摘要、分类、信息抽取。这类应用开发较快,但更适合通用场景,不太适合大量数据的简单批量化处理。

自然语言接口:将 LLM 连接知识库或工具,实现问答或基本工具使用的自动化。这可以用于构建专业聊天机器人,但其实际价值受其所连接的知识库质量等其他因素影响。

工作流自动化:使用 LLM 实现业务流程的标准化和自动化。这可以应用于较复杂的区块链数据处理流程,如解构智能合约运行过程、风险识别等。

协助机器人与助手辅助系统:辅助系统是在自然语言接口的基础上,集成更多数据源和功能的增强系统,大幅提高用户工作效率。

图 11:LLM 应用场景

3.6 LLM 的局限性

3.6.1 行业现状:成熟应用、正在攻克的问题以及尚未解决的挑战

在 Web3 数据领域,尽管已经取得了一些重要的进展,但仍然面临一些挑战。

相对成熟的应用:

使用 LLM 进行信息处理:LLM 等 AI 技术已成功用于生成文本摘要、总结、解释等工作,帮助用户从长篇文章、专业报告中提取关键信息,提高了数据的可读性和可理解性。

使用 AI 解决开发问题:LLM 已经应用于解决开发过程中的问题,例如替代StackOverflow 或搜索引擎,为开发者提供问题解答和编程支持。

有待解决与正在探索的问题:

利用 LLM 生成代码:行业正在努力将 LLM 技术应用于自然语言到 SQL 查询语言的转换,以提高数据库查询的自动化和可理解性。然而,过程中会有很多困难,比如在某些情境下,生成的代码要求极高的准确性,语法必须百分之百正确,以确保程序能够无 bug 运行,并获得正确的结果。难点还包括确保问题回答的成功率、正确率,以及对业务的深刻理解。

数据标注问题:数据标注对于机器学习和深度学习模型的训练至关重要,但在 Web3 数据领域,特别是处理匿名的区块链数据时,标注数据的复杂性较高。

准确性和幻觉(Hallucination)问题:AI 模型中幻觉的出现可能受多因素影响,包括有偏见或不足的训练数据、过度拟合、有限的上下文理解、缺乏领域知识、对抗性攻击和模型架构。研究人员和开发者需要不断改进模型的训练和校准方法,以提高生成文本的可信度和准确性。

利用数据进行业务分析和文章输出:将数据用于业务分析和生成文章仍然是一个具有挑战性的问题。问题的复杂性、需要精心设计的提示(prompt)、以及高质量的数据、数据量、减少幻觉问题的方法都是待解决的问题。

根据业务领域自动索引智能合同数据以进行数据抽象:自动为不同业务领域的智能合同数据建立索引以进行数据抽象仍然是一个未解决的问题。这需要综合考虑不同业务领域的特点,以及数据的多样性和复杂性。

处理时序数据,表格文档数据等更复杂的模态:DALL·E 2 等多模态模型非常擅长在文字生成图像、语音等常见模态。而在区块链以及金融领域需要特别地对待一些时序数据,而非简单地把文本向量化就能解决。联和时序数据与文本,跨模态联合训练等,是实现数据智能分析以及应用的重要研究方向。

3.6.2 为何只靠 LLM 不能完美解决区块链数据行业的问题

作为语言模型,LLM 更适用于处理对流畅度要求较高的场景,而在追求准确性方面,可能需要对模型进行更进一步的调整。在将 LLM 应用于区块链数据行业时,以下框架可提供一些参考。

图 13:区块链数据行业下 LLM 输出的流畅性、准确性和用例风险

在评估 LLM 在不同应用中的适用性时,关注流畅度和准确性是至关重要的。流畅度指的是模型的输出是否自然、通顺,准确性则表示模型的答案是否准确。这两个维度在不同应用场景中有不同的要求。

对于流畅度要求较高的任务,如自然语言生成、创意写作等,LLM 通常能够胜任,因为其在自然语言处理方面的强大性能使其能够生成流畅的文本。

区块链数据面临着数据解析、数据处理、数据应用等多方面的问题。LLM 拥有卓越的语言理解和推理能力,使其成为与区块链数据互动、整理和概括的理想工具。然而,LLM 并不能解决所有区块链数据领域的问题。

在数据处理方面,LLM 更适合快速迭代和探索性处理链上数据,不断尝试新的处理方法。然而,LLM 在生产环境中的详细核对等任务方面仍存在一些限制。典型的问题是 token 长度不够,无法应对长上下文的内容。耗时的 prompt,回答不稳定影响下游任务进而导致成功率不稳定的问题,以及执行大批量任务的效率不高。

其次,LLM 处理内容的过程中很可能出现幻觉问题。据估计,ChatGPT 的幻觉概率约为 15% 至 20%,而由于其处理过程的不透明性,很多错误难以察觉。因此,框架的建立和专家知识的结合变得至关重要。此外,LLM 结合链上数据还是有很多挑战:

链上数据实体类型多、数量庞大,以何种形式投喂给 LLM,有效地运用在具体的商业化场景,类似其他垂直行业,需要更多研究和探索。

链上数据包括结构化和非结构化数据,目前行业大多数数据解决方案,都是基于对业务数据的理解。解析链上数据的过程中,用 ETL 去过滤,清洗,补充和复原业务逻辑,进一步把非结构化数据整理为结构化数据,可以为后期多种业务场景提供更高效的分析。比如,结构化的 DEX trades,NFT marketplace transactions,wallet address portfolio 等,就具有前面提到的高质量,高价值,准确和真实等特点,可以给通用 LLM 提供高效的补充。

4.被误解的 LLM

LLM 可以直接处理非结构化数据,因此结构化数据将不再被需要?

LLM 通常基于海量文本数据预训练而来,天然适合处理各类非结构化的文本数据。然而,各个行业已经拥有大量结构化数据,尤其 Web3 领域中解析后的数据。如何有效的利用这些数据,增强 LLM,是一个行业的热门研究课题。

对于 LLM,结构化数据仍然具有以下的优势:

海量:大量的数据储存在各种应用背后的数据库和其他标准格式里面,特别是私有数据。每个公司和行业都还有大量 LLM 没有用于预训练的墙内数据。

已有:这些数据不需要重新生产,投入成本极低,唯一的问题是怎么用起来。

高质量和高价值:领域内长期积累的,蕴含专家的专业知识,通常都沉淀到了结构化数据里面,用于产学研。结构化数据的质量是数据可用性的关键,其中包括数据的完整性、一致性、准确性、唯一性和事实性。

高效率:结构化数据以表格、数据库或其他规范格式存储,模式是预先定义的,并且在整个数据集中保持一致。这意味着数据的格式、类型和关系都是可预测和可控的,使得数据的分析和查询更加简单和可靠。而且,行业已经有成熟的 ETL 及各种数据处理和管理工具,使用起来也更加高效和便捷。LLM 可以通过 API,把这些数据使用起来。

准确性和事实性:LLM 的文本数据,基于 token 概率,目前还不能稳定的输出确切的答案,产生的幻觉问题一直是 LLM 要解决的核心根本问题。对于很多行业和场景,会形成安全和可靠性问题,比如,医疗,金融等。结构化数据,正是可以辅助和矫正LLM 这些问题的一个方向。

体现关系图谱,和特定业务逻辑:不同类型的结构化数据,可以以特定的组织形式(关系型数据库,图数据库等),输入到 LLM,解决不同类型的领域问题。结构化数据使用标准化的查询语言(如 SQL),使得对数据进行复杂的查询和分析变得更加高效和准确。知识图谱 (Knowledge Graph) 可以更好地表达实体之间的关系,也更容易进行关联查询。

使用成本低:不用 LLM 每次重新从底层重新训练整个底座模型,可以结合 Agents 和LLM API 等 LLM 赋能方式,更快更低成本的接入 LLM。

目前市场上还有一些脑洞大开的观点,认为 LLM 在处理文本信息和非结构化信息方面的能力极强,只需将原始数据,包括非结构化数据,简单导入到 LLM,就能达到目的。这个想法类似于要求通用 LLM 解数学题,在没有专门构建数学能力模型的情况下,大多数 LLM 可能会在处理简单的小学加减题时出错。反而,建立类似数学能力模型,和图像生成模型的 Crypto LLM 垂直模型,才是解决 LLM 在 Crypto 领域更落地的实践。

4.2 LLM 可以从新闻、推特等文字信息推测内容,人们不再需要链上数据分析来得出结论?

LLM 虽然可以从新闻、社交媒体等文本中获得信息,但直接从链上数据中获得的洞察仍然是不可或缺的,主要原因有:

链上数据是原始的第一手资讯,而新闻和社交媒体中的信息可能存在片面性或误导性。直接分析链上数据可以减少信息偏差。尽管利用 LLM 进行文本分析存在理解偏差的风险,但直接分析链上数据可以减少误读。

链上数据包含全面的历史交互和交易记录,分析可以发现长期趋势和模式。链上数据还可以展现整个生态系统的全貌,如资金流向、各方关系等。这些宏观的洞察有助于更深入地理解状况。而新闻和社交媒体信息通常更零散且短期。

链上数据是开放的。任何人都可以验证分析结果,避免信息的不对称。而新闻和社交媒体未必都如实披露。文本信息和链上数据可以相互验证。综合两者可以形成更立体和准确的判断。

链上数据分析仍是不可或缺的。LLM 从文本中获取信息具有辅助作用,但不能取代直接分析链上数据。充分利用两者优势才能取得最佳效果。

4.3 利用 LangChain、LlamaIndex 或其他 AI 工具,在 LLM 的基础上构建区块链数据解决方案非常容易?

LangChain 和 LlamaIndex 等工具为构建自定义的简单 LLM 应用提供了便利,使快速搭建成为可能。然而,将这些工具成功应用于实际生产环境中涉及到更多的挑战。构建一个高效运行、保持高质量的 LLM 应用是一项复杂的任务,需要深入理解区块链技术和 AI 工具的工作原理,并有效地将它们整合在一起。这对于区块链数据行业来说,是一项重要但具有挑战性的工作。

在这个过程中,必须认识到区块链数据的特性,它要求极高的精准性和可重复校验性。一旦数据通过 LLM 进行处理和分析,用户对其准确性和可信度有很高的期望。这与 LLM 的模糊容错性之间存在着潜在的矛盾。因此,在构建区块链数据解决方案时,必须仔细权衡这两方面的需求,以满足用户的期望。

当前市场上,虽然已经有了一些基础工具,但这个领域仍在快速演进和不断迭代。类比于 Web2 世界的发展历程,从最初的 PHP 编程语言到更成熟、可扩展的方案如 Java、Ruby、Python,以及 JavaScript 和 Node.js 等,再到 Go 和 Rust 等新兴技术,都经历了不断的演变。AI 工具也在不断变化,新兴的 GPT 框架如 AutoGPT,Microsft AutoGen,及最近OpenAI 自己推出的 ChatGPT 4.0 Turbo 的 GPTs 和 Agents 等只是展示了未来可能性的一部分。这表明,区块链数据行业和 AI 技术都还有许多发展空间,需要不断努力和创新。

当前在应用 LLM 时,有两个陷阱需要特别注意:

期望值过高:很多人认为 LLM 可以解决一切问题,但实际上 LLM 有明显的局限性。它需要大量的计算资源,训练成本高昂,而且训练过程可能不稳定。对 LLM 的能力要有现实的期望,明白它在某些场景下表现出色,如自然语言处理和文本生成,但在其他领域可能无法胜任。

忽视业务需求:另一个陷阱是强行应用 LLM 技术,而不充分考虑业务需求。在应用 LLM 之前,务必明确具体的业务需求。需要评估 LLM 是否是最佳技术选择,并做好风险评估和控制。强调 LLM 的有效应用需要根据实际情况慎重考虑,避免误用。

尽管 LLM 在许多领域都具备巨大潜力,但开发者和研究者在应用 LLM 时需要保持谨慎,采取开放的探索态度,以找到更适合的应用场景并最大程度地发挥其优势。

5.Web3 数据行业与 AI 结合的现状以及发展路线

5.1 Dune

Dune 是当前 Web3 行业内领先的开放数据分析社区,提供了区块链查询、提取和可视化大量数据的工具,允许用户和数据分析专家使用简单的 SQL 查询从 Dune 预先填充的数据库中查询链上数据,并形成相应的图表和观点。

2023 年 3 月,Dune 提出关于 AI 以及未来结合 LLM 的计划,并于 10 月发布了其 Dune AI 产品。Dune AI 相关的产品核心关注利用 LLM 强大的语言能力和分析能力增强 Wizard UX ,更好地为用户提供 Dune上的数据查询和 SQL 编写。

(1)查询解释:3 月发布的产品,用户可以通过点击按钮来获取 SQL 查询的自然语言解释,旨在帮助用户更好地理解复杂的 SQL 查询,从而提高数据分析的效率和准确性。

(2)查询翻译:Dune 计划将 Dune 上不同的 SQL 查询引擎(如 Postgres 和 Spark SQL)统一迁移到 DuneSQL,因此 LLM 可以提供自动化的查询语言翻译能力,帮助用户更好地过渡,以有利于 DuneSQL 产品的推行。

(3)自然语言查询:即 10 月发布的 Dune AI。允许用户用普通英语提问并获取数据。这一功能的目标是使得无需 SQL 知识的用户也能轻松获取和分析数据。

(4)搜索优化:Dune 计划利用 LLM 改进搜索功能,帮助用户更有效地筛选信息。

(5)向导知识库:Dune 计划发布一个聊天机器人,帮助用户快速浏览 Spellbook 和 Dune 文档中的区块链和 SQL 知识。

(6)简化 SQL 编写工作(Dune Wand):Dune 8 月推出 Wand 系列的 SQL 工具。Create Wand 允许用户从自然语言提示中生成完整的查询,Edit Wand 并允许用户对现有查询进行修改,Debug 功能自动调试查询中的语法错误。这些工具的核心都是 LLM 技术,能够简化查询编写过程,使分析师能够专注于分析数据的核心逻辑,无需担心代码和语法问题。

5.2 Footprint Analytics

Footprint Analytics,是一家区块链数据解决方案提供商,借助人工智能技术,提供无代码数据分析平台、统一的数据 API 产品以及 Web3 项目 BI 平台 Footprint Growth Analytics。

Footprint 的优势在于其链上数据生产线及生态工具的打造,其通过建立统一的数据湖打通链上链下数据和类链上工商登记的元数据库,确保用户在分析以及使用时的数据的可获取性、易用性和质量。Footprint 的长期战略将专注于技术深度和平台建设,以打造能够生产链上数据以及应用的“机器工厂”。

Footprint 产品与 AI 的结合如下:

自 LLM 模型推出以后,Footprint 在第一时间便在探索现有数据产品与 AI 的结合,以提高数据处理和分析的效率,打造对用户更友好的产品。2023 年 5 月份,Footprint 已开始为用户提供自然语言交互的数据分析功能,并在其原有无代码的基础上升级到了高阶产品功能,用户在无需熟悉平台的表格、设计的情况下,即可通过对话快速获取数据以及生成图表。

此外,目前市场中 LLM + Web3 的数据产品,主要集中在解决降低用户使用门槛,交互范式的变更上的问题,而 Footprint 在产品与 AI 的开发中的重点,不仅是帮助用户解决数据分析使用体验的问题,其重点还在于沉淀 crypto 领域的垂类数据与业务理解,以及训练加密领域语言模型,提升垂直场景应用的效率以及准确度。Footprint 在这方面的优势将体现在以下方面:

数据知识量(知识库的质与量)。数据积累的效率,源、量、类别。特别是 Footprint MetaMosaic 子产品上,体现关系图谱,以及特定业务逻辑的静态数据的积累。

知识架构。Footprint 已经积累了超过 30 条公链的,按业务版块抽象的结构化数据表。原始数据到结构化数据的生产流程知识,可以反过来加强对原始数据的理解,更好去训练模型。

数据类型。从链上非标准非结构化的原始数据开始训练以及从结构化、具有业务意义的数据表以及指标的训练,从训练的效率以及机器成本上都有明显的差距。一个比较典型的是需要提供比较多的数据去提供给 LLM,这些数据除了需要基于加密领域的专业数据, 也需要更多易读、结构化的数据,另外更大的用户量的作为反馈数据。

Crypto 资金流向数据。Footprint 把跟投资紧密相关的资金流向数据进行了抽象,它包含了每笔交易的时间、主体(含流向)、代币类型、金额(关联时点代币价格)、业务类型,以及代币、主体的标签,可作为 LLM 的知识库以及数据源,用于做代币的主力资金分析、定位筹码分布、监测资金流向、识别链上异动、追踪聪明资金等。

私有数据的注入。Footprint 把模型分为 3 大层,一个是具备 World knowledge 的底座大模型(OpenAI 以及其他开源模式)、细分领域垂直模型、个性化专家知识模型。让用户能把自己不同源的知识库统一在 Footprint 上去进行管理,并且利用私有数据去训练私有 LLM,适用于更个性化的应用场景。

在 Footprint 结合 LLM 模型探索中,也遇到了一系列的挑战和问题,其中最典型的就是token 不足、耗时的 prompt 提示以及回答不稳定等问题。而 Footprint 所处的链上数据这一垂直领域,面临的更大挑战是链上数据实体类型多、数量庞大,变化快,以何种形式投喂给 LLM,需要整个行业更多研究和探索。目前的工具链也还相对初期,还需要更多的工具去解决一些具体问题。

未来 Footprint 在技术和产品上与 AI 的结合包括以下内容:

(1)技术方面,Footprint 将结合 LLM 模型在三个方面进行探索和优化

支持 LLM 在结构化数据上进行推理,让已沉淀的大量加密领域的结构化数据以及知识,能够被应用在 LLM 的数据消费以及生产上。

帮助用户建立个性化知识库(包括知识、数据以及经验),以及使用私有数据去提升已经优化过的 crypto LLM 的能力,让每个人都能建自己的模型。

让 AI 辅助分析以及内容生产,用户可以通过对话的方式,结合资金流数据以及私有知识库,去创建自己的 GPT,去生产以及分享 crypto 投资内容。

(2)在产品方面,Footprint 将重点探索 AI 产品应用以及商业模式上的创新。根据 Footprint 近期对产品的推广计划,将推出为用户提供 AI crypto 内容生成与分享平台。

此外,对于未来合作伙伴的拓展,Footprint 将在以下两个方面进行探索:

第一,强化与跟 KOL 合作,助力有价值内容的生产以及社区的运营、知识的变现。

第二,拓展更多合作项目方以及数据提供方,打造一个开放、共赢的用户激励和数据合作,建立一个互利共赢的一站式数据服务平台。

5.3 GoPlus SecurityGoplus

GoPlus Security是目前 Web3 行业领先的用户安全基础设施,提供各类面向用户的安全安全服务。目前已经被市面上主流的数字钱包、行情网站、Dex 以及其他各种 Web3 应用所集成。用户可以直接使用资产安全检测、转账授权和防钓鱼等各种安全保护功能。GoPlus所提供的用户安全解决方案可以全方位覆盖整个用户安全的生命周期,以保护用户资产免受各种类型的攻击者的威胁。

GoPlus 与 AI 的发展与规划如下:

GoPlus 在 AI 技术方面主要探索体现在其 AI 自动化检测和 AI 安全助手两款产品中:

(1)AI 自动化检测

GoPlus 从 2022 年开始自研基于AI技术的自动化检测引擎,来全面提升安全检测的效率以及准确率。GoPlus的安全引擎采用多层次、漏斗式的分析方法,采用了静态代码检测、动态检测以及特征或行为检测等多个环节。这一复合式检测流程使得引擎能够有效地识别并分析潜在风险样本的特征,从而对攻击类型和行为有效建模。这些模型是引擎识别和预防安全威胁的关键,它们帮助引擎判断风险样本是否具有某些特定的攻击特征。此外,GoPlus安全引擎经过长时间的迭代和优化,积累了非常丰厚的安全数据以及经验,其架构能够快速有效应对新出现的安全威胁,确保能够及时发现并阻止各种复杂和新型的攻击,全方位保护用户安全。目前该引擎在风险合约检测、钓鱼网站检测、恶意地址检测以及风险交易检测等多个安全场景均使用了AI相关的算法和技术。采用AI技术能更快速地缩短减小风险敞口,提高检测效率,降低检测成本;另一方面减少了人工参与的复杂性和时间成本,提高对风险样本判断的准确率,尤其是对于那些原本人工难以界定或引擎难以识别的新场景,通过AI可以更好地归集特征并形成更有效的分析方法。

2023 年,随着大模型的发展,GoPlus 迅速适应并采用了 LLM。与传统 AI算法相比,LLM 在数据识别、处理和分析方面的效率和效果有了显著提升。LLM 的出现帮助 GoPlus 加快了在 AI 自动化检测方面的技术探索,在动态模糊测试的方向上,GoPlus采用了LLM技术能够有效的生成交易序列,探索更深的状态来发现合约风险。

(2)AI 安全助手

GoPlus 同时正利用基于 LLM 的自然语言处理能力,开发 AI 安全助手,以提供即时的安全咨询和改善用户体验。AI 助手基于 GPT 大模型,通过前端业务数据的输入,开发了一套自研的用户安全Agent,能够根据问题自动化的去分析、生成解决方案、拆解任务、执行,为用户提供需要的安全服务。AI 助手能简化用户与安全问题之间的交流,降低用户理解的门槛。

在产品功能上,由于 AI 在安全领域的重要性,未来 AI 有潜力彻底改变现有的安全引擎或病毒杀毒引擎的结构,出现以 AI 为核心的全新引擎架构。GoPlus 将持续对 AI 模型进行训练和优化,以期将AI从辅助工具转变为其安全检测引擎的核心功能。

在商业模式上,虽然目前 GoPlus 的服务主要面向开发者和项目方,但公司正在探索更多直接面向 C 端用户的产品和服务,以及与AI相关的新收入模式。提供高效、准确、低成本的 C 端服务将是 GoPlus 未来的核心竞争力。这需要公司持续研究,在与用户交互的 AI 大模型上进行更多的训练和输出。同时,GoPlus公司也将与其他团队合作,共享其安全数据,并通过合作推动安全领域内的 AI 应用,为未来可能带来的行业变革做好准备。

5.4 Trusta Labs

Trusta Labs成立于2022年,是一家由人工智能驱动的Web3领域数据创业公司。Trusta Labs专注于利用先进的人工智能技术对区块链数据进行高效处理和精准分析,以构建区块链的链上声誉和安全基础设施。目前,Trusta Labs 的业务主要包括两款产品:TrustScan 和 TrustGo。

(1)TrustScan,TrustScan是一款专为B端客户设计的产品,主要用于帮助Web3项目在用户获取、用户活跃和用户留存方面进行链上用户行为分析和精细化分层,以识别高价值且真实的用户。

(2)TrustGo,一款面向 C 端客户的产品,其提供的 MEDIA 分析工具,可以从五个维度(资金金额、活跃度、多样性、身份权益、忠诚度)对链上地址进行分析和评估,该产品强调对链上数据的深入分析,以提升交易决策的质量和安全性。

Trusta Labs 与 AI 的发展与规划如下:

目前 Trusta Labs 的两款产品均是利用AI模型对链上地址的交互数据进行处理和分析。区块链上地址交互的行为数据,均属于序列数据,这类型的数据非常适合用于 AI 模型的训练。在对链上数据进行清洗、整理和标记的过程中,Trusta Labs 将大量的工作交给 AI 来完成,极大地提高了数据处理的质量和效率,同时也减少了大量的人力成本。Trusta Labs 利用 AI 技术对链上地址交互数据进行深入分析和挖掘,对于 B 端客户而言,可以有效地识别出较大可能性的女巫地址。在已使用 Tursta Labs 产品的多个项目中,Tursta Labs 均较好地防范了潜在女巫攻击的发生;而对于 C 端客户,通过 TrustGo 产品,利用现有的 AI 模型,有效帮助用户深入了解了自己的链上行为数据。

Trusta Labs一直在紧密关注LLM模型的技术进展和应用实践。随着模型训练和推理成本不断降低,以及Web3领域大量语料和用户行为数据的积累,Trusta Labs将寻找合适的时机,引入LLM技术,利用 AI 的生产力为产品和用户提供更深入的数据挖掘和分析功能。在目前 Trusta Labs 已经提供丰富的数据的基础上,希望可以利用 AI 的智能分析模型,为数据结果提供更多合理、客观的数据解读功能,如针对 B 端用户提供定性和定量解读已抓取到女巫账户的分析,让用户更理解数据背后的原因分析,同时可以为 B 端用户向其客户投诉解释时提供更翔实的材料佐证。

另一方面,Trusta Labs 也计划利用已开源或者较为成熟的 LLM 模型,并结合以意图为中心的设计理念来构建 AI Agent,从而来帮助用户更快捷、更效率地解决链上交互的问题。就具体应用场景而言,未来通过 Trusta Labs 提供的基于 LLM 训练的 AI Agent 智能助理,用户可以直接通过自然语言与智能助理进行交流,智能助理即可“聪明”地反馈链上数据相关的信息,并针对已提供的信息进行后续操作的建议和规划,真正实现以用户意图为中心的一站式智能操作,极大降低用户使用数据的门槛,简化链上操作的执行。

此外,Trusta 认为,未来随着越来越多基于 AI 的数据产品的出现,每个产品的核心竞争要素可能不在于使用何种 LLM 模型,竞争的关键因素是对已掌握数据更深层次的理解和解读。基于对已掌握数据的解析,再结合 LLM 模型,才能训练出更“聪明”的 AI 模型。

5.5 0xScope

0xScope,成立于 2022 年,是一个以数据为核心的创新平台,其专注于区块链技术和人工智能的结合。0xScope 旨在改变人们处理、使用和看待数据的方式。0xScope 目前针对 B 端和 C 端客户分别推出了:0xScope SaaS products 和 0xScopescan。

(1)0xScope SaaS products,一个面向企业的 SaaS 解决方案,赋能企业客户进行投后管理、做出更好的投资决策、了解用户行为,并密切监控竞争动态。

(2)0xScopescan,一个 B2C 产品 ,其允许加密货币交易者调查选定区块链的资金流动和活动情况。

0xScope 的业务重点是利用链上数据抽象出通用数据模型,简化链上数据分析工作,将链上数据转化为可被理解的链上操作数据,从而帮助用户对链上数据进行深入分析。利用 0xScope 提供的数据工具平台,不仅可以提升链上数据质量,挖掘数据暗藏的信息,从而揭示更多的信息给用户,该平台也极大降低了数据挖掘的门槛。

0xScope 与 AI 的发展与规划如下:

0xScope 的产品正在结合大模型进行升级,这包含两个方向:第一,通过自然语言交互的模式进一步地降低用户的使用门槛;第二,利用 AI 模型提高在数据清洗、解析、建模和分析等环节的处理效率。同时,0xScope 的产品中即将上线具有 Chat 功能的 AI 互动模块,该功能将极大地降低用户进行数据查询和分析的门槛,仅通过自然语言即可与底层的数据进行交互和查询。

但在训练和使用AI的过程中,0xScope 发现其中仍面临这以下挑战:第一,AI 训练成本和时间成本较高。在提出一个问题后,AI 需要花费较长时间才能进行回复。因此,这个困难会迫使团队需要精简和聚焦业务流程,专注于垂直领域的问答,而不是让其成为一个全方位的超级AI助理。第二,LLM 模型的输出是不可控的。数据类的产品希望给出的结果是精准的,但目前LLM模型给出的结果很可能与实际的情况有一定出入,这对数据类产品的体验是非常致命的。此外,大模型的输出有可能会涉及到用户的隐私数据。因此,在产品中使用 LLM 模式时,团队需要对其有较大程度的限制,以使得 AI 模型输出的结果可控且精准。

未来,0xScope 计划利用 AI 专注于特定的垂直赛道并进行深耕。目前基于已大量积累大量链上数据,0xScope 可以对链上用户的身份进行定义,后续将继续利用 AI 工具抽象链上用户行为,进而打造出一套独特的数据建模的体系,通过这套数据挖掘和分析体系揭示出链上数据暗含的信息。

在合作方面,0xScope 将聚焦在两类群体:第一类,产品可以直接服务的对象,比如开发者、项目方、VC、交易所等,该群体需要目前产品所提供的数据;第二类,对 AI Chat 有需求的合作伙伴,如 Debank、Chainbase 等,他们只需要有相关的知识和数据,便可以直接调用 AI Chat。

6.VC insight——AI+Web3 数据公司的商业化和未来发展之路

本节内容通过采访了 4 位资深的 VC 投资人,将从投资和市场的视角来看 AI+Web3 数据行业的现状和发展,Web3 数据公司的核心竞争力以及未来的商业化道路。

6.1 AI+Web3 数据行业的现状和发展

目前,AI 与 Web3 数据的结合正处于一个积极探索的阶段,从各个头部 Web3 数据公司的发展方向来看,AI 技术以及 LLM 的结合都是必不可少的趋势。但同时 LLM 有其自身技术局限性,尚不能解决当前数据行业的很多问题。

因此,我们需要认识到并非盲目地与 AI 结合就能够增强项目的优势,或者是使用 AI 概念进行炒作,而是需要探索真正具有实用性和前景的应用领域。从 VC 的视角,目前 AI 与 Web3数据的结合已经有以下方面的探索:

(1)通过 AI 技术来提高Web3 数据产品的能力,包括 AI 技术帮助企业提高内部数据处理分析的效率,以及相应提高对用户的数据产品的自动化分析、检索等能力。例如 SevenX Ventures 的Yuxing 提到 Web3 数据使用 AI 技术最主要的帮助是效率方面,比如 Dune 使用 LLM 模型做代码异常检测和将自然语言转化生成 SQL 去信息索引;还有用 AI 做安全预警的项目,AI 算法做异常检测效果比从纯数学统计更好,所以可以更有效地去做安全方面的监测;此外,经纬创投的子熹提到企业可以通过训练 AI 模型进行数据的预标注,能节约很多人力成本。尽管如此,VC 们都认为,在提高 Web3 数据产品的能力和效率方面,AI 起到的是辅助作用,例如数据的预标注,最终可能仍需要人工审核来确保准确性。

(2)利用 LLM 在适应性和交互上的优势,打造 AI Agent/Bot。例如使用大语言模型来检索整个 Web3 的数据,包括链上数据和链下新闻数据,进行信息聚合和舆情分析。Hashkey Capital 的 Harper 认为这类的 AI Agent更加偏向于信息的整合、生成,以及和用户之间的交互,在信息准确性和效率上会相对弱一些。

上述两方面的应用尽管已经有不少案例,但是技术和产品仍然在探索的早期,因此未来也需要不断地进行技术优化和产品改进。

(3)利用 AI 进行定价及交易策略分析:目前市场中有项目利用 AI 技术给 NFT 进行价格估算,如启明创投投资的 NFTGo,以及有些专业交易团队使用 AI 进行数据分析和交易执行。此外 Ocean Protocol 近期也发布了一个价格预测的AI产品。这类的产品似乎很有想象力,但在产品中、用户接受程度方面,尤其是准确性方面仍需要进行验证。

另一方面,有不少 VC,尤其是在 Web2 有投资的 VC会更关注提到 Web3 和区块链技术能够为 AI 技术带来的优势和应用场景。区块链具有公开可验证、去中心化的特点,以及密码学技术提供隐私保护能力,加上 Web3 对生产关系重塑,可能能够给 AI 带来一些新的机会:

(1)AI 数据确权与验证。AI 的出现使数据内容生成变得泛滥和廉价。启明创投的唐弈提到对于数字作品等内容,难以确定其质量和创作者。在这方面,数据内容的确权需要一个全新的体系,区块链可能可以提供帮助。经纬创投的子熹提到有数据交易所将数据放在NFT中进行交易,可以解决数据确权的问题。

另外,SevenX Ventures 的 Yuxing 提到Web3 数据能够改善 AI 造假和黑盒问题,当前 AI 在模型算法本身和数据方面都存在黑盒问题,会导致输出结果的偏差。而Web3的数据具有透明性,数据是公开可验证的,AI模型的训练源和结果都会更加明晰,使得AI更加公正,减少偏见和错误。但当前 Web3 的数据量还不够多,不足以给 AI 本身的训练赋能,因此短期不会实现。但是我们可以利用这一特性,将 Web2 数据上链,来防止 AI 的深度伪造。

(2)AI 数据标注众包及 UGC 社区:目前传统 AI 标注面临效率和质量较低的问题,尤其是在涉及到专业知识领域,可能还需要交叉学科知识,传统的通用数据标注公司是不可能覆盖的,往往需要专业团队内部来做。而通过区块链和 Web3 的概念引入数据标注的众包,则能很好地改善这个问题,例如经纬创投投资的Questlab,他们使用区块链技术提供数据标注的众包服务。此外,在一些开源模型社区中,也可以使用区块链概念来解决模型创作者经济的问题。

(3)数据隐私部署:区块链技术结合密码学相关技术可以保证数据的隐私和去中心化。经纬创投的子熹提到他们投资的一个合成数据公司,通过大模型生成合成数据去使用,数据可以主要应用在软件测试、数据分析,以及 AI 大模型训练使用。公司在处理数据的时候涉及到很多隐私部署的问题,使用了 Oasis区块链,可以有效避免了隐私和监管问题。

6.2 AI+Web3 数据公司如何打造核心竞争力

对于 Web3 技术公司来说,AI 的引入能够一定程度上增加项目的吸引力或关注度,但是目前大部分 Web3 技术公司相关结合 AI 的产品并不足以成为公司的核心竞争力,更多是在提供了更友好的体验,以及效率的提升。譬如 AI Agent 的门槛并不高,先做的公司可能在市场有先发优势,但并不产生壁垒。

而真正在 Web3 数据行业中产生核心竞争力和壁垒的应该是团队的数据能力以及如何应用 AI 技术解决具体分析场景的问题。

首先,团队的数据能力包括了数据源及团队进行数据分析和模型调整的能力,这是进行后续工作的基础。在采访中,SevenX Ventures、经纬创投和 Hashkey Capital 都一致提到了 AI+Web3 数据公司的核心竞争力取决于数据源的质量。在这个基础上,还需要工程师能够基于数据源熟练地进行模型微调、数据处理和解析。

另一方面,团队 AI 技术具体结合的场景也非常重要,场景应该是有价值的。Harper 认为,尽管目前 Web3 数据公司与 AI 的结合基本都是从 AI Agent 开始,但他们的定位也不同,例如 Hashkey Capital 投资的 Space and Time,和 chainML 合作推出了创建 AI agent 的基础设施,其中创建的 DeFi agent 被用于 Space and Time。

6.3 Web3 数据公司未来的商业化道路

另一个对于 Web3 数据公司很重要的话题是商业化。长期以来,数据分析公司的盈利模式都比较单一,大都 ToC 免费,主要 ToB 盈利,这很依赖于 B 端客户的付费意愿。在 Web3 领域,本身企业的付费意愿就不高,加上行业初创公司为主,项目方难以支撑长期的付费。因此目前 Web3 数据公司在商业化的处境上比较艰难。

在这个问题上,VC 们普遍认为当前 AI 技术的结合,仅应用在内部解决生产流程的问题,并没有改变本质上的变现难问题。一些新的产品形式如 AI Bot 等门槛不够高,可能一定程度上在 toC 领域增强用户的付费意愿,但仍然不是很强。AI 可能短期内不是解决数据产品商业化问题的解决方案,商业化需要更多的产品化努力,例如寻找更加合适的场景,和创新的商业模式。

在未来 Web3 与 AI 结合的路径上,利用 Web3 的经济模型结合 AI 数据可能会产生一些新的商业模式,主要在 ToC 领域。经纬创投的子熹提到 AI 产品可以结合一些 token 的玩法,提高整个社群的粘性、日活和情感,这是可行的,也更容易变现。启明创投的唐弈提到,从意识形态的角度,Web3 的价值体系可以结合到AI上的,很适合作为 bot 的账号体系或者说价值转化体系。例如一个机器人拥有自己的账户,可以通过其智能部分赚钱,以及为维护其底层计算能力付费等。但这个概念属于未来的畅想,实际应用可能还有很长的路要走。

而在原来的商业模式,即用户直接付费上,需要有足够强的产品力,让用户有更强的付费意愿。例如更高质量的数据源、数据带来的效益超过支付的成本等,这不仅仅在于 AI 技术的应用,也在数据团队本身的能力之上。

注册有任何问题请添加 微信:MVIP619 拉你进入群

打开微信扫一扫

添加客服

进入交流群

1.本站遵循行业规范,任何转载的稿件都会明确标注作者和来源;2.本站的原创文章,请转载时务必注明文章作者和来源,不尊重原创的行为我们将追究责任;3.作者投稿可能会经我们编辑修改或补充。